Jeder, der schon einmal einen wichtigen Webcast produziert hat, kennt das Gefühl danach: Die Live-Veranstaltung war ein Erfolg, die Teilnehmenden waren begeistert – doch was passiert jetzt mit dem wertvollen Inhalt? Viel zu oft landet die Aufzeichnung in einem Archiv und das Potenzial verpufft. Das ist die "One-and-Done"-Falle.

Bei MEETYOO glauben wir, dass jeder Webcast der Anfang, nicht das Ende sein sollte. Er ist eine Goldmine für wiederverwendbare Inhalte. Die große Frage ist nur: Wie findest du die Goldnuggets in einem 60-minütigen Video, ohne Stunden mit manueller Sichtung zu verbringen?

Die Antwort liegt in der künstlichen Intelligenz. Aber – und das ist entscheidend – nicht jede KI ist für diese Aufgabe gleich gut geeignet. Um das zu beweisen, haben wir getan, was uns als Software-Unternehmen im Blut liegt: Wir haben es getestet.

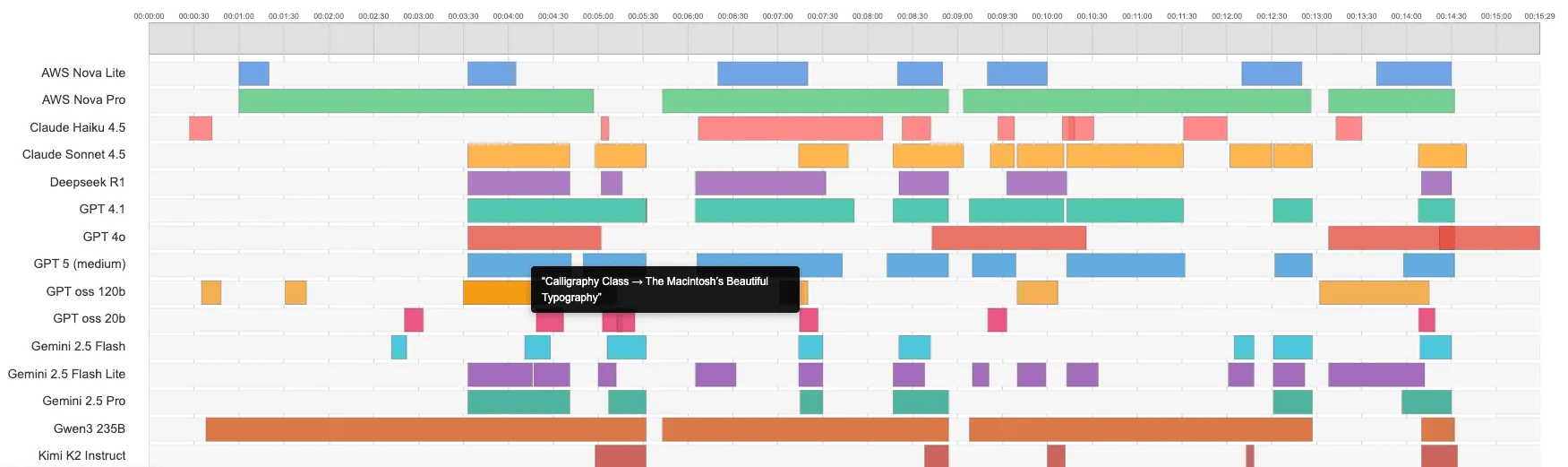

Das Experiment: 17 KI-Modelle gegen zwei der berühmtesten Reden der Welt

Wir wollten wissen, wie gut die aktuellsten Large Language Models (LLMs) darin sind, die "Key Moments" in einem Transkript zu identifizieren. Also gaben wir ihnen eine klare Aufgabe: Analysiere die Transkripte von Steve Jobs' Stanford-Rede 2005 und John F. Kennedys "Ich bin ein Berliner"-Rede 1963 und extrahiere die Momente, die sich perfekt für kurze Videoclips eignen.

Die Kriterien waren streng: Die Momente mussten Zitate, Anekdoten oder Kernaussagen enthalten, zwischen 10 Sekunden und 2 Minuten lang sein und ohne weiteren Kontext funktionieren.

Die 17 LLM Kontrahenten im Überblick

Um ein breites Spektrum abzudecken, haben wir Modelle von etablierten Anbietern, aufstrebenden Spezialisten und aus der Open-Source-Community ausgewählt.

| Provider/Creator | Model Name | Intelligence Index |

|---|---|---|

| DeepSeek | DeepSeek R1 🧠 | 52 |

| Gemini 2.5 Flash Lite 🧠 | 40 | |

| Gemini 2.5 Flash 🧠 | 51 | |

| Gemini 2.5 Pro 🧠 | 60 | |

| Gemini 3 Pro 🧠 | 73 | |

| OpenAI | GPT-5.1 (medium) 🧠 | 70 |

| OpenAI | GPT-5 (medium) 🧠 | 66 |

| OpenAI | GPT OSS 20B 🧠 | 52 |

| OpenAI | GPT OSS 120B 🧠 | 61 |

| OpenAI | GPT-4.1 | 43 |

| OpenAI | GPT-4o | 29 |

| Alibaba | Qwen3 235B | 57 |

| Anthropic | Claude 4.5 Haiku 🧠 | 70 |

| Anthropic | Claude 4.5 Sonnet 🧠 | 55 |

| Moonshot AI | Kimi K2 Instruct | 48 |

| Amazon | Nova Lite | 21 |

| Amazon | Nova Pro | 25 |

| 🧠 = Reasoning-Modell. Daten von Artificial Analysis. |

Eine ehrliche Einschränkung: Die Trainingsdaten-Falle

Bevor wir zu den Ergebnissen kommen, ist eine kritische Einordnung wichtig. Diese beiden Reden sind Ikonen der Popkultur und mit an Sicherheit grenzender Wahrscheinlichkeit Teil der Trainingsdaten fast aller Modelle. Die KIs "kennen" diese Inhalte also bereits.

Warum haben wir sie trotzdem gewählt? Weil es für die Identifikation von "Highlights" keine objektive Wahrheit gibt. Bei einem unbekannten internen Webcast könnten wir die Qualität der KI-Vorschläge kaum fair bewerten. Die berühmten Reden bieten einen allgemein anerkannten Konsens darüber, was die Schlüsselmomente sind. So konnten wir testen, wie gut die Modelle den menschlichen Konsens über Relevanz und Kontext verstehen – eine entscheidende Fähigkeit für die Content-Wiederverwertung. Der wahre Test ist und bleibt natürlich Material, das die KI noch nie gesehen hat.

Unser Werkzeug: Der Prompt, den wir mit dir teilen

Ein gutes Ergebnis hängt nicht nur vom Modell ab, sondern auch massiv von der Qualität des Prompts. Wir haben viel Zeit investiert, um unsere Anweisung so präzise wie möglich zu formulieren. Weil wir an den Wert von Transparenz und Partnerschaft glauben, teilen wir ihn hier mit dir:

<role>

You are a video content analyst specializing in

identifying compelling moments for short-form content creation.

</role>

<task>

Analyze the provided VTT transcript to extract key moments that would make engaging short-form video clips.

</task>

<input_format>

Standard VTT (WebVTT) format with timestamps and text content.

</input_format>

<key_moment_criteria>

A key moment must contain at least one of:

• **Important quote** - memorable, quotable statement

• **Key insight** - valuable learning or revelation

• **Interesting metric** - surprising statistic or data point

• **Compelling anecdote** - engaging story or example

• **Actionable advice** - practical tip or strategy

Requirements:

• Duration: 10 seconds minimum, 2 minutes maximum

• Self-contained: makes sense without additional context

• High value: provides significant insight or entertainment

• Clip-worthy: suitable for standalone short-form content

</key_moment_criteria>

<output_format>

For each key moment, provide:

**Title:** [Descriptive title that captures the essence]

**Start Time:** [HH:MM:SS]

**End Time:** [HH:MM:SS]

**Type:** [Quote/Insight/Metric/Anecdote/Advice]

**Why Notable:** [Brief explanation of value/impact]

---

</output_format>

<guidelines>

• Focus on quality over quantity - extract only the most compelling moments

• Avoid overlapping time segments

• Prioritize moments with emotional impact or practical value

• Ensure each moment tells a complete micro-story

• If uncertain about timing, reply "TIMESTAMP_UNCLEAR"

</guidelines>

**VTT Transcript:**

...

Die drei entscheidenden Erkenntnisse aus unserem Test

Das Ergebnis war mehr als nur eine Rangliste. Es hat drei grundlegende Wahrheiten über den Einsatz von KI für die Maximierung deines Content-ROI aufgedeckt.

Erkenntnis 1: Es gibt keinen "einen" Sieger – und das ist die wichtigste Erkenntnis

Die größte Überraschung war: Kein einzelnes Modell hat alle anderen deklassiert. Stattdessen zeigten die KIs unterschiedliche "Persönlichkeiten".

Einige Modelle, wie Qwen3 oder AWS Nova Pro, neigten dazu, lange, kapitelähnliche Blöcke zu identifizieren. Sie haben die Reden quasi in ihre Hauptabschnitte zerlegt. Das ist nützlich für eine grobe Gliederung, aber ungeeignet für die Erstellung von Social-Media-Clips.

Andere, wie die Gemini-Familie von Google, lieferten konsequent kürzere, prägnantere Momente. Sie agierten eher wie "Moment-Spotter" statt wie "Kapitel-Finder".

Was das für dich bedeutet: Eine KI-Plattform, die nur auf ein einziges Allzweck-Modell setzt, wird dir niemals das volle Spektrum an wertvollen Inhalten liefern. Der Schlüssel liegt darin, die Stärken verschiedener Modelle zu verstehen und sie gezielt einzusetzen.

Erkenntnis 2: Teuer ist nicht immer besser – auf die Aufgabe kommt es an

Man könnte annehmen, dass die größten und teuersten Modelle automatisch die besten Ergebnisse liefern. Unser Test hat das Gegenteil bewiesen.

Einige der vermeintlichen Top-Modelle lieferten enttäuschende, weil zu allgemeine Ergebnisse. Die wahren Juwelen fanden sich oft bei spezialisierteren oder kleineren Modellen. Das beste Beispiel: Das Open-Source-Modell GPT-OSS-20b war das einzige, das bei Steve Jobs den subtilen, aber extrem kraftvollen Moment "The Power of Dropping Out" identifizierte. Ein echter "Hidden Gem", den die Giganten übersehen haben.

Was das für dich bedeutet: Es geht nicht darum, die meiste Rechenleistung auf ein Problem zu werfen. Es geht darum, die richtige Art von Intelligenz für die spezifische Aufgabe der Content-Analyse zu nutzen. Eine intelligente Plattform verlässt sich nicht auf Markennamen, sondern auf nachgewiesene Ergebnisse.

Erkenntnis 3: Kurze Impulse schlagen lange Kapitel

Für Content-Manager*innen ist die Verwertbarkeit entscheidend. Ein 5-minütiges "Highlight" ist kein Highlight, es ist ein Kapitel. Ein 45-sekündiger, pointierter Clip hingegen ist pures Gold. Du kannst ihn auf LinkedIn teilen, in einen Newsletter einbetten oder als Teaser für die On-Demand-Version deines Webcasts nutzen.

Unser Test hat gezeigt, dass die Fähigkeit einer KI, wirklich kurze, in sich geschlossene Momente zu erkennen, der entscheidende Faktor für den praktischen Nutzen ist. Eine lange Liste an Vorschlägen ist wertlos, wenn jeder Vorschlag erst mühsam von dir gekürzt werden muss.

Was das für dich bedeutet: Dein Ziel ist es, den Aufwand für die Wiederverwertung zu minimieren und den Output zu maximieren. Eine KI muss dir deshalb nicht nur sagen, was interessant ist, sondern es dir in einem Format liefern, das du sofort weiterverwenden kannst.

Erlebe die Ergebnisse selbst: Unsere interaktive Demo

Wir können viel über die Unterschiede erzählen – aber am besten überzeugst du dich selbst. Wir haben eine einfache, interaktive Demo gebaut, in der du die Ergebnisse der verschiedenen Modelle für beide Reden direkt vergleichen kannst. Klicke dich durch und entdecke selbst, welche KI die "Hidden Gems" findet und welche eher an der Oberfläche kratzt.

Hier geht es zur interaktiven Demo

Unser Fazit: Expertise ist der entscheidende Faktor

Dieser Test bestätigt unsere Kernphilosophie bei MEETYOO: Es reicht nicht, einfach nur KI auf ein Produkt zu kleben. Echter Mehrwert entsteht erst, wenn tiefgreifende Expertise in die Entwicklung der Software einfließt.

Wir haben diese Forschung betrieben, weil wir verstehen, was du als Kommunikations- oder Marketing-Profi brauchst: keine theoretischen Möglichkeiten, sondern praktische, effiziente Lösungen, die deinen Content-ROI messbar steigern. Die Erkenntnisse aus diesem und vielen weiteren Tests fließen direkt in unsere Plattform MEETYOO Show ein. So stellen wir sicher, dass unsere KI nicht nur intelligent ist, sondern vor allem eines: nützlich.

Denn wir bieten dir nicht irgendeine Software. Wir bieten dir Software for Decisive Moments. Backed by Experts.